声明

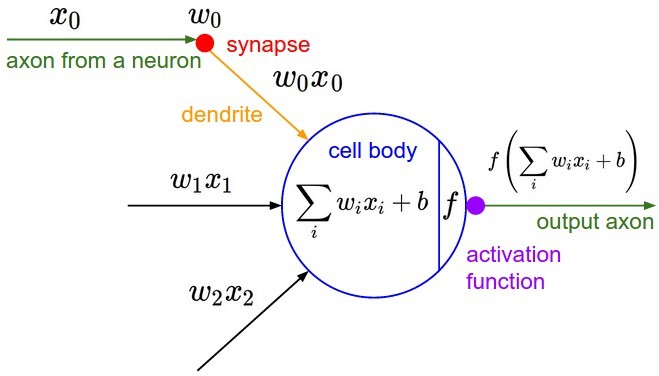

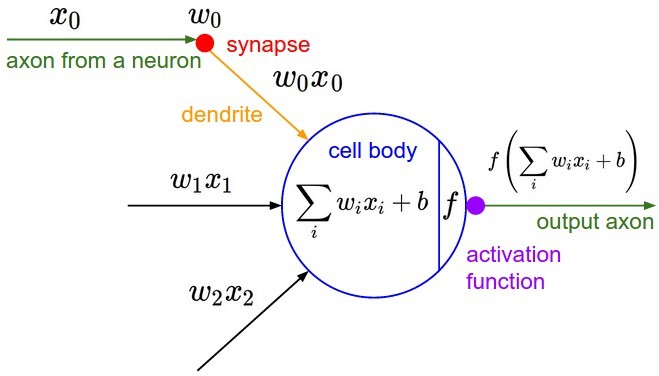

神经元

- 该神经元整合前一层神经元的消息为z(x,w,b)=∑iwixi+b,再送到激活函数f(z)。这里整合的过程是线性加权。

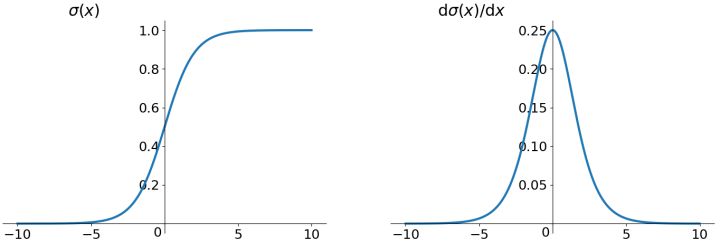

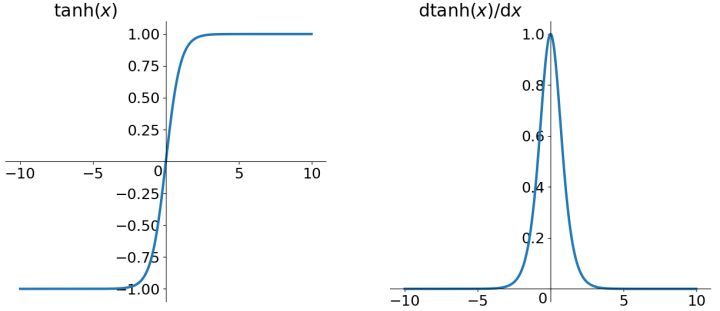

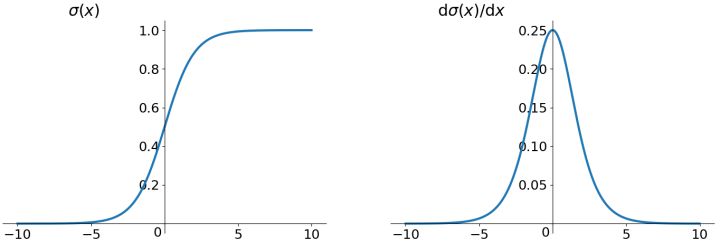

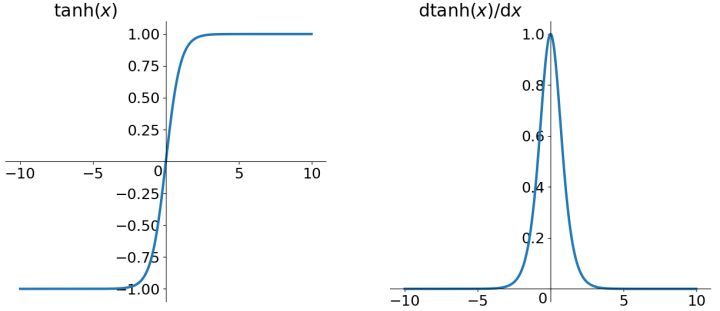

Sigmoid和tanh

σ(z)=1+e−z1

-tanh函数的一般形式为

tanh(z)=ez+e−zez−e−z

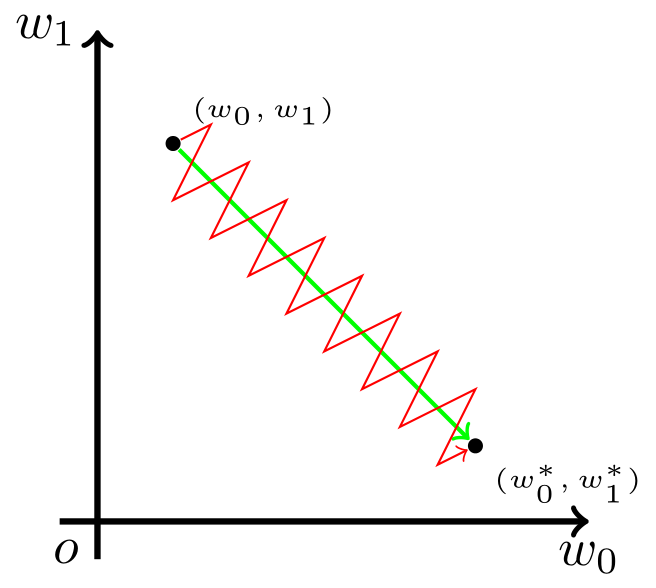

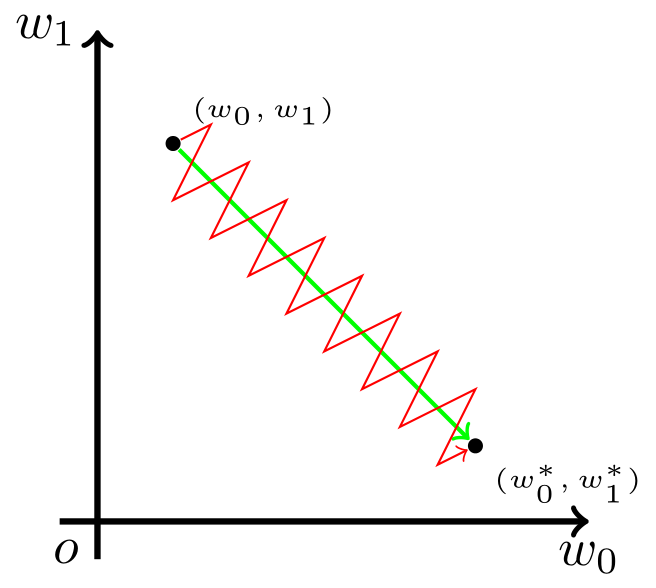

收敛速度

- 模型的最优解即是模型参数的最优解,通过多轮迭代,模型参数会被更新到接近最优解,这一过程,迭代次数越多,收敛速度越慢;反之,迭代次数越少,收敛速度越快。

参数更新

- 深度学习一般的学习方法是反向传播。简单来说,就是通过链式法则,求解全局损失函数L(x)对某一参数w的偏导数(梯度);然后辅以学习率η,向梯度的反方向更新参数w。

w←w−η⋅∂w∂L

- 考虑学习率η是全局设置的超参数,参数更新的核心步骤是计算∂w∂L,再考虑到对于某个神经元来说,输入和输出的关系是:

f(x;w,b)=f(z)=f(i∑wixi+b).

∂wi∂L=∂f∂L∂z∂f∂wi∂z=xi⋅∂f∂L∂z∂f.

wi←wi−ηxi⋅∂f∂L∂z∂f.

更新方向

{xi⋅∂f∂L∂z∂fxj⋅∂f∂L∂z∂f

- 因此每个w更新方向,由此时的xi的方向决定。假设当前情况下,wi变小合适,wj变大合适。但在Sigmoid函数中,输出值恒为正。也就是说如果上一级神经元采用Sigmoid函数作为激活函数,那么我们无法做到xi和xj方向相反。此时模型为了收敛,只能Z字形逼近最优解